Искусственный интеллект способен обучаться как ребенок

Языковые модели, такие как GPT-4, обучаются на огромных массивах данных — триллионы слов, — тогда как маленькие дети узнают на порядки меньше понятий в год. Может ли искусственный интеллект обучаться подобно ребенку? Именно это проверили исследователи из Нью-Йорка, обучив языковую модель на наборе слов, которые узнает младенец, когда начинает учиться говорить.

Скриншот канала Нью-Йоркского Университета

Как дети начинают запоминать слова, сопоставляя их со значением, и какие механизмы обучения в этом задействованы? Одна из известных теорий гласит, что усвоение слов происходит благодаря простым ассоциативным механизмам обучения, таким как отслеживание совпадений между стимулами. Достаточно ли будет простой схемы, основанной на ассоциативном обучении, для запоминания слов языковой моделью? Таким вопросом задались авторы публикации в Science.

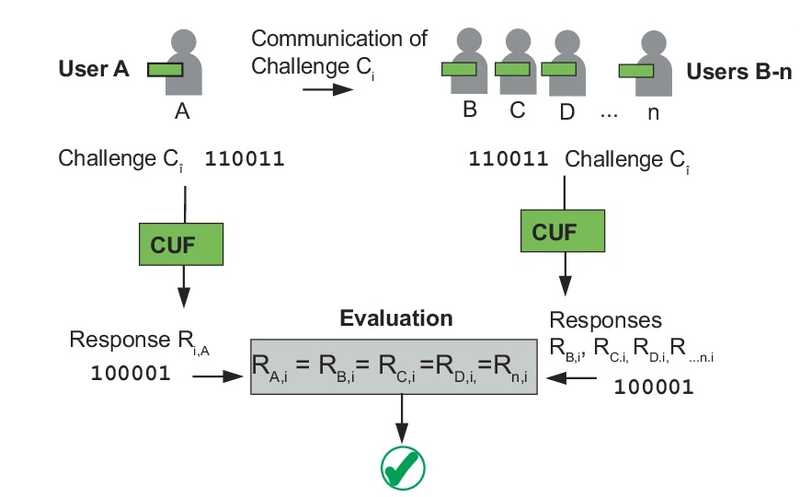

Чтобы на него ответить, ученые воспользовались методом контрастивного обучения. Они представили модель CVCL (Child’s View for Contrastive Learning), которая сопоставляет слова с возможными визуальными референтами (конкретными объектами, к которым относится слово). Эта модель представляет собой форму ассоциативного обучения.

Исследователи проверили, будет ли модель обучаться подобно маленькому ребенку, если будет воспринимать мир его глазами и ушами. Они закрепляли видеокамеру на голове шестимесячного младенца и отслеживали визуальные образы, а также соотносящиеся с ними слова, которые узнавал ребенок. Наблюдение продолжалось до возраста 25 месяцев. Всего ученые набрали 61 час видеоматериала, на котором они обучили ИИ. Модели давали на вход кадры видео, содержащие те или иные предметы, и записи речи родителей, обращенной к ребенку, — то есть визуальную и лингвистическую информацию.

После обучения модель проверяли на способность теми же способами, которыми тестируют запоминание новых слов у детей. В ходе тестирования CVCL предъявляли слово и четыре изображения, среди которых она должна была выбрать одно, соответствующее заданному слову. Оказалось, что модель смогла выучить значительное количество понятий, которые присутствуют в повседневном опыте маленького ребенка. Средняя точность классификации составила 61,6%. При этом для 11 из 22 протестированных понятий точность классификации оказалась в пределах 5% от верхней границы производительности CLIP — другой контрастивной нейросети, обученной на 400 млн пар «изображение—текст».

Кроме того, некоторые выученные слова языковая модель смогла обобщить на другие визуальные примеры, подобно тому, как это делают дети. Исследователи продемонстрировали это на отдельном наборе данных. Он содержал 64 изображения тех же категорий, что уже были известны CVCL и успешно идентифицировались ей ранее, однако в этом случае изображения были представлены на белом фоне — с этим модель раньше не сталкивалась. Оказалось, что 16 из 64 понятий модель распознавала с точностью более 50%, а еще 42 — с точностью выше случайной. Общая точность в этом случае составила 34,7%.

Представленная модель эффективно обучилась на данных, полученных от одного ребенка. Такой подход реалистично отражает индивидуальное развитие, в отличие от совокупных наборов данных, поскольку детям приходится учиться говорить, опираясь только на ограниченный набор слов, с которыми они сталкиваются сами. Полученные в данном исследовании результаты важны также для теорий усвоения языка. Альтернативные теории предполагают наличие сильных индуктивных установок, специализированных языковых механизмов или иных когнитивных способностей. Однако на CVCL ученые показали, что обучения представлениям и ассоциативных механизмов достаточно для того, чтобы научиться сопоставлять слово с референтом на основе опыта отдельного ребенка.Имитация работы NMDA-рецептора улучшила обучение ИИ

Источник

Wai Keen Vong et al. , Grounded language acquisition through the eyes and ears of a single child. // Science 383, 504-511 (2024). DOI: 10.1126/science.adi1374

Меню

Меню

Все темы

Все темы

0

0